Miernik

Czy to niekończąca się odległość do domu babci, przęsło tkaniny, liczba jardów do linii bramkowej, czy przestrzeń między niezgłębialnie małymi tranzystorami na chipie komputerowym, długość jest jedną z najbardziej znanych jednostek miary.

Ludzie wymyślili wiele różnych pomysłowych sposobów mierzenia długości. Najbardziej intuicyjne z nich są na wyciągnięcie ręki. To znaczy, opierają się na ludzkim ciele: stopie, dłoni, palcach, długości ramienia lub kroku.

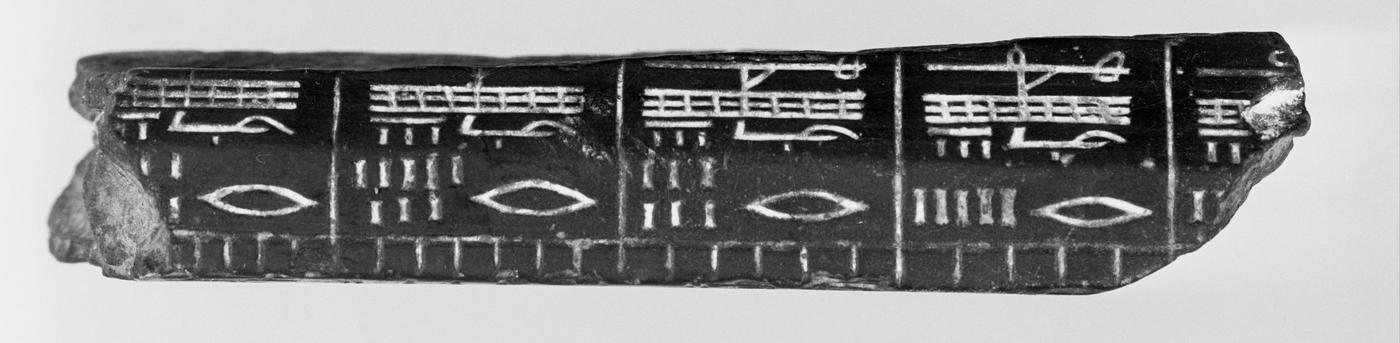

W starożytnej Mezopotamii i Egipcie, jedną z pierwszych standardowych miar długości był kubit. W Egipcie, królewski kubit, który był używany do budowy najważniejszych budowli, opierał się na długości ramienia faraona od łokcia do końca środkowego palca plus rozpiętość jego dłoni. Ze względu na jego wielkie znaczenie, królewski kubit został znormalizowany za pomocą prętów wykonanych z granitu. Te granitowe kubity były dalej dzielone na krótsze długości przypominające centymetry i milimetry.

Późniejsze pomiary długości stosowane przez Rzymian (którzy przejęli je od Greków, którzy przejęli je od Babilończyków i Egipcjan) i przekazane do Europy generalnie opierały się na długości ludzkiej stopy lub chodu oraz wielokrotnościach i poddziałach tej długości. Na przykład, tempo – jeden krok w lewo plus jeden krok w prawo – to w przybliżeniu metr lub jard (z drugiej strony, jard nie pochodzi od tempa, ale między innymi od długości wyciągniętego ramienia króla Anglii Henryka I). Mille passus po łacinie, czyli 1000 kroków, to właśnie stąd pochodzi angielskie słowo „mila”. Jednak rzymska mila nie była tak długa, jak jej współczesna wersja.

Rzymianie i inne kultury z całego świata, takie jak te w Indiach i Chinach, ustandaryzowały swoje jednostki, ale pomiary długości w Europie były nadal w dużej mierze oparte na zmiennych rzeczach aż do XVIII wieku. Na przykład w Anglii, dla celów handlowych, cal był rozumiany jako długość trzech jęczmieni ułożonych koniec do końca.

Jednostka długości służąca do pomiaru ziemi, pręt, była długością 16 losowo wybranych stóp męskich, a jej wielokrotność określała akr.

W niektórych miejscach obszar ziemi uprawnej był nawet mierzony w czasie, np. ile ziemi człowiek, lub człowiek z wołem, mógł zaorać w ciągu jednego dnia. Ta miara dalej zależała od uprawianej rośliny: Na przykład, akr pszenicy był innej wielkości niż akr jęczmienia. To było w porządku tak długo, jak długo dokładność i precyzja nie były problemem. Można było zbudować własny dom, używając takich miar, a działki ziemi można było z grubsza zbadać, ale jeśli chciało się kupić lub sprzedać cokolwiek na podstawie długości lub powierzchni, pobrać odpowiednie podatki i cła, zbudować bardziej zaawansowaną broń i maszyny z wymiennymi częściami lub przeprowadzić jakiekolwiek badania naukowe, potrzebny był uniwersalny standard.

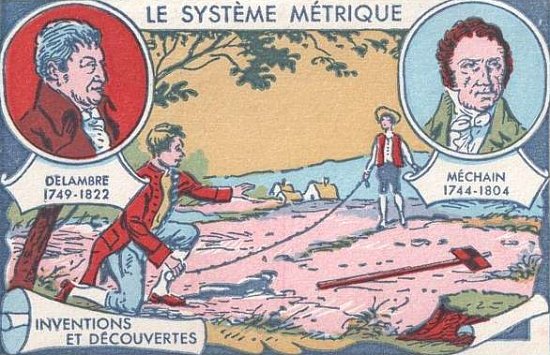

Wynalezienie systemu metrycznego pod koniec XVIII wieku w rewolucyjnej Francji było wynikiem długotrwałych wysiłków zmierzających do ustanowienia takiego uniwersalnego systemu miar, który nie opierałby się na wymiarach ciała różniących się w zależności od osoby lub miejsca. Francuzi starali się raczej stworzyć system, który przetrwałby „po wsze czasy, dla wszystkich ludów”.

Aby tego dokonać, Francuska Akademia Nauk powołała w 1790 roku radę złożoną z wybitnych naukowców i matematyków: Jean-Charlesa de Bordy, Josepha-Louisa Lagrange’a, Pierre’a-Simona Laplace’a, Gasparda Monge’a i Nicolasa de Condorceta, którzy mieli zbadać ten problem. Rok później opracowali oni zestaw zaleceń. Nowy system miał być systemem dziesiętnym, to znaczy opartym na liczbie 10 i jej potęgach. Miara odległości, metr (pochodzący od greckiego słowa metron, oznaczającego „miarę”), miałaby wynosić 1/10 000 000 odległości między biegunem północnym a równikiem, przy czym linia ta miałaby oczywiście przebiegać przez Paryż. Miarą objętości, litrem, byłaby objętość sześcianu wody destylowanej, którego wymiary wynosiłyby 1/1000 metra sześciennego. Jednostka masy (lub bardziej praktycznie, wagi), kilogram, byłaby wagą litra wody destylowanej w próżni (całkowicie pustej przestrzeni).

W 1792 roku astronomowie Pierre Méchain i Jean-Baptiste Delambre wyruszyli, by zmierzyć metr, badając odległość między Dunkierką we Francji a Barceloną w Hiszpanii. Po około siedmiu latach starań doszli do ostatecznej miary i przedstawili ją Akademii, która przyjęła prototyp metra w postaci sztabki platyny.

Później odkryto, że naukowcy popełnili błędy w obliczaniu krzywizny Ziemi, w wyniku czego oryginalny prototyp metra był o 0.2 milimetry krótszy niż rzeczywista odległość między biegunem północnym a równikiem. Choć nie wydaje się to dużą rozbieżnością, jest to jednak rzecz, która spędza sen z powiek naukowcom zajmującym się pomiarami. Mimo to zdecydowano, że miernik pozostanie taki, jaki jest realizowany w platynowej sztabce. Kolejne definicje miernika były od tego czasu wybierane tak, aby jak najściślej trzymać się długości tego pierwszego metrowego pręta, pomimo jego niedociągnięć.

W miarę upływu czasu coraz więcej krajów europejskich przyjmowało metr francuski jako swój standard długości. Jednak, mimo że kopie paska metra miały być dokładne, nie było sposobu, aby to zweryfikować. W 1875 roku na mocy Traktatu o Miarach, podpisanego przez 17 krajów, w tym Stany Zjednoczone, powołano do życia Generalną Konferencję Miar i Wag (Conférence Général des Poids et Mésures, CGPM) jako formalną organizację dyplomatyczną odpowiedzialną za utrzymanie międzynarodowego systemu jednostek miar w harmonii z postępem nauki i przemysłu.

W tym samym czasie powstała również organizacja międzyrządowa, Międzynarodowe Biuro Miar i Wag (Bureau international des poids et mesures, BIPM). Zlokalizowane pod Paryżem, w Sèvres, we Francji, BIPM służy jako punkt centralny, poprzez który państwa członkowskie podejmują działania w sprawach o znaczeniu metrologicznym. Jest ostatecznym arbitrem Międzynarodowego Układu Jednostek Miar (SI, Système Internationale d’Unités) i repozytorium wzorców miar fizycznych. Kilogram był ostatnim z opartych na artefaktach wzorców miar w SI. (20 maja 2019 r. został oficjalnie zastąpiony nową definicją opartą na stałych przyrody.)

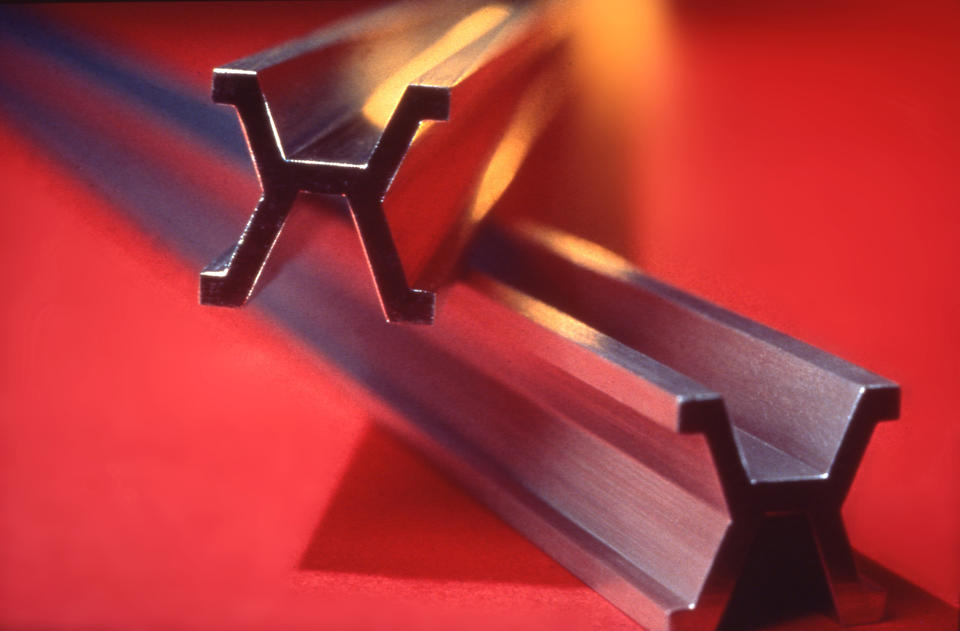

Po tym pierwszym spotkaniu BIPM zamówił nowy prototyp i 30 egzemplarzy zostało przekazanych krajom członkowskim. Ten nowy prototyp miał być wykonany z platyny i irydu, co było znacznie trwalsze niż sama platyna. Pręt nie byłby już płaski, lecz miałby przekrój w kształcie litery X, aby lepiej opierać się zniekształceniom, które mogłyby powstać w wyniku zginania podczas porównywania z innymi prętami pomiarowymi. Nowy prototyp nie byłby również standardem „końcowym”, w którym licznik byłby definiowany przez końce pręta. Zamiast tego, pręt miałby ponad metr długości, a metr byłby definiowany jako odległość pomiędzy dwiema liniami zapisanymi na jego powierzchni. Napisy te, łatwiejsze do wykonania niż wzorzec końcowy, umożliwiały również przetrwanie pomiarów w przypadku uszkodzenia końców pręta. Oficjalne pomiary prototypu miernika miałyby miejsce przy standardowym ciśnieniu atmosferycznym w temperaturze topnienia lodu.

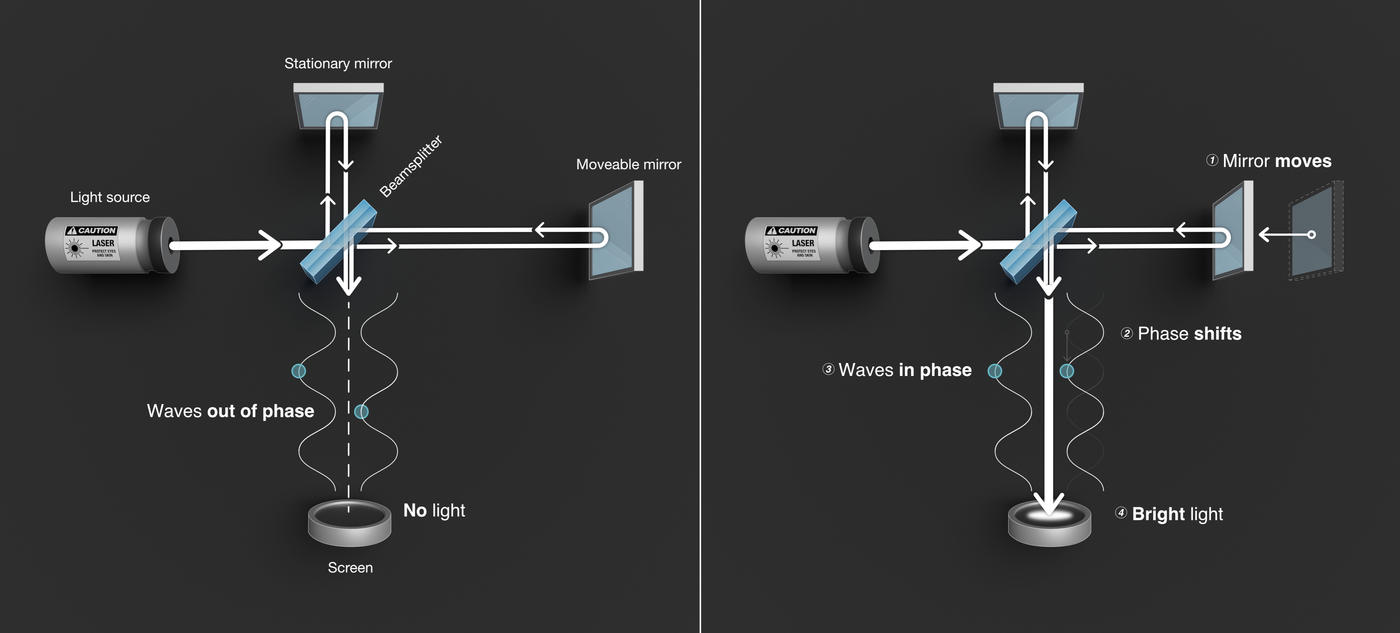

I tak było aż do 1927 roku, kiedy to precyzyjny pomiar metra mógł dokonać kwantowego skoku dzięki postępom poczynionym w 40-letniej technice znanej jako interferometria. W tej technice fale świetlne mogą być manipulowane w taki sposób, że łączą się lub „interferują” ze sobą, umożliwiając precyzyjne pomiary długości fal – odległości pomiędzy kolejnymi szczytami.

W 1927 roku NIST (wówczas znane jako National Bureau of Standards) opowiedziało się za tym, aby wzory interferencyjne wzbudzonych atomów kadmu stały się praktycznym standardem długości. Było to użyteczne, ponieważ międzynarodowe artefakty pomiarowe, takie jak pręty pomiarowe, nie mogły być wszędzie jednocześnie; jednakże, przy odpowiednim wyposażeniu, naukowcy w każdym miejscu mogli mierzyć metr kadmem. Ich kopie, jakkolwiek znakomite, nie są tak dokładne jak prawdziwe. Ani artefakt, ani jego kopie nie nadają się do każdego pomiaru, jaki można by chcieć wykonać. Aby przytoczyć jeden przykład z życia, bloki wzorcowe są wzorcami długości powszechnie używanymi w obróbce skrawaniem. Ze względu na niezwykle precyzyjną pracę wymaganą od maszynistów, ich wzorce kalibracyjne muszą być również precyzyjnie wykonane. Używając długości fal kadmu (i kryptonu), bloki wzorcowe mogą być certyfikowane jako dokładne z dokładnością do 0,000001 cala na każdy cal (1 część na milion), trzy razy bliżej niż poprzednio.

W połowie lat 40. fizycy jądrowi wycelowali neutrony w złoto, aby przekształcić atomy w rtęć. Fizyk NIST William Meggers zauważył, że skierowanie fal radiowych na tę formę rtęci, znaną jako rtęć-198, spowoduje powstanie zielonego światła o ściśle określonej długości fali. W 1945 r. Meggers zdobył niewielką ilość rtęci-198 i zaczął z nią eksperymentować.

Zastosowawszy techniki interferometryczne do rtęci-198, trzy lata później wymyślił precyzyjny, powtarzalny i wygodny sposób określania miernika.

„Najprawdopodobniej zielona linia rtęci będzie falą, która zostanie użyta jako ostateczny standard długości” – napisał w swoich pracach.

Meggers zmierzył długość fali zielonego światła z rtęci: 546,1 nanometrów, czyli miliardowych części metra. Metr zostałby zdefiniowany jako dokładna liczba wielokrotności tej długości fali.

W 1951 roku NIST rozprowadził 13 „lamp Meggersa” do instytucji naukowych i laboratoriów przemysłowych. Agencja dążyła do dalszego zwiększenia precyzji swojej techniki redefinicji metra. Jednak fundusze na ten cel nie były dostępne od razu, a projekt nie mógł zostać ukończony do 1959 roku.

W końcu rtęć przegrała z kryptonem – pierwiastkiem atomowym, od którego nazwę wzięła ojczysta planeta Supermana. Izotop kryptonu-86, pierwotnie zaproponowany jako atom z wyboru przez Physikalisch-Technische Bundesanstalt (PTB), narodowy instytut metrologiczny Niemiec, był szerzej dostępny w Europie i mógł zapewnić wyższą precyzję pomiarów laboratoryjnych w tamtym czasie.

Więc w 1960 roku, 11 CGPM uzgodniło nową definicję metra jako „długość równą 1,650,763.73 długościom fali w próżni promieniowania odpowiadającego przejściu pomiędzy poziomami 2p10 i 5d5 atomu kryptonu-86”. Innymi słowy, kiedy elektrony powszechnej formy kryptonu wykonują określony skok energetyczny, uwalniają tę energię w postaci czerwono-pomarańczowego światła o długości fali 605,8 nanometrów. Dodaj do siebie 1,650,753.73 tych długości fal i masz metr.

Ale standard kryptonu nie miał przetrwać zbyt długo. (Przykro mi, Supermanie.) A to dlatego, że naukowcy z NIST szybko rozwinęli inną superbohaterską moc: zdolność do wiarygodnego i precyzyjnego pomiaru najszybszej prędkości we wszechświecie, czyli prędkości światła w próżni.

Światło, z którym jesteśmy najbardziej zaznajomieni, rodzaj widzialny, jest tylko małą częścią spektrum elektromagnetycznego, które rozciąga się od fal radiowych do promieniowania gamma. Tak więc, kiedy mówimy o prędkości światła, mówimy o prędkości całego promieniowania elektromagnetycznego, w tym światła widzialnego.

Ponieważ światło ma niewiarygodnie szybką, ale ostatecznie skończoną prędkość, jeśli ta prędkość jest znana, wtedy odległości mogą być obliczone przy użyciu prostego wzoru: Odległość to prędkość pomnożona przez czas. Jest to świetny sposób na zmierzenie odległości do satelitów i innych statków kosmicznych, Księżyca, planet, a przy zastosowaniu pewnych dodatkowych technik astronomicznych, nawet bardziej odległych obiektów niebieskich. Prędkość światła jest również podstawą sieci GPS, która określa Twoją pozycję poprzez pomiar czasu przelotu sygnałów radiowych pomiędzy wyposażonymi w zegar atomowy satelitami a Twoim smartfonem lub innym urządzeniem. A znajomość prędkości światła jest integralną częścią innej, ściśle powiązanej technologii zwanej namierzaniem laserowym, hiperdokładnego rodzaju radaru, który może być wykorzystywany do pozycjonowania satelitów oraz mierzenia i monitorowania powierzchni Ziemi.

Prędkość światła przez wieki pozostawała nieuchwytną wielkością, ale naukowcy zaczęli się do niej naprawdę zbliżać wraz z wynalezieniem lasera w 1960 r., w tym samym roku, w którym wprowadzono standard kryptonowy. Charakterystyka światła laserowego sprawiła, że stało się ono idealnym narzędziem do pomiaru długości fali światła. Jedyne, czego brakowało w równaniu nist, to bardzo dokładny pomiar częstotliwości światła, czyli liczby szczytów fali, które przechodzą przez ustalony punkt w ciągu sekundy. Gdy częstotliwość była już znana z wystarczającą dokładnością, obliczenie prędkości światła było tak proste, jak pomnożenie częstotliwości przez długość fali.

W latach 1969-1979 naukowcy z laboratorium NIST w Boulder w stanie Kolorado dokonali dziewięciu rekordowych pomiarów częstotliwości światła laserowego. Na uwagę zasługuje rekordowy pomiar z 1972 roku, w którym wykorzystano nowatorski laser stabilizowany w celu uwolnienia określonej częstotliwości światła. Światło silnie oddziaływało z gazem metanem, zapewniając, że podobne lasery będą działać z tą samą częstotliwością, więc eksperyment można powtórzyć. Pomiar ten był o wiele bardziej powtarzalny niż cokolwiek w zatwierdzonej w 1960 r. technice określania miernika. Prowadzony przez fizyków z NIST, Kena Evensona, przyszłego laureata nagrody Nobla Jana Halla i Dona Jenningsa, doprowadził do uzyskania wartości c=299 792 456,2 ± 1,1 metra na sekundę, co stanowiło stukrotną poprawę dokładności przyjętej wartości prędkości światła.

Niezależnie od grupy NIST z Boulder, Zoltan Bay i Gabriel Luther z siedziby NIST w Gaithersburgu, we współpracy z Johnem White’em, kolegą z American University, opublikowali kilka miesięcy wcześniej nową wartość prędkości światła. Grupa z Gaithersburga wykorzystała pomysłowy schemat modulowania światła z linii 633 nm lasera helowo-neonowego za pomocą mikrofal. Używając wartości dla długości fali czerwonej linii He-Ne podanej wcześniej przez Christophera Sidenera, Bay, Luther i White uzyskali wartość c=299,792,462 ± 18 metrów na sekundę. Wartość ta, choć nie została określona z tak niskim poziomem niepewności, jak kilka miesięcy później twierdziła grupa z Boulder, była całkowicie zgodna z ich wynikami.

W oparciu o te i inne postępy, metr został ponownie zdefiniowany przez międzynarodową umowę w 1983 roku jako długość drogi przebytej przez światło w próżni w ciągu 1/299 792 458 sekundy. Definicja ta określiła również prędkość światła na 299 792 458 metrów na sekundę w próżni. Długość nie była już niezależnym standardem, ale raczej była pochodną niezwykle dokładnego standardu czasu i nowo zdefiniowanej wartości prędkości światła, możliwej dzięki technologii opracowanej w NIST.

I tak oto metr został i prawdopodobnie pozostanie elegancko zdefiniowany w tych warunkach w przewidywalnej przyszłości.